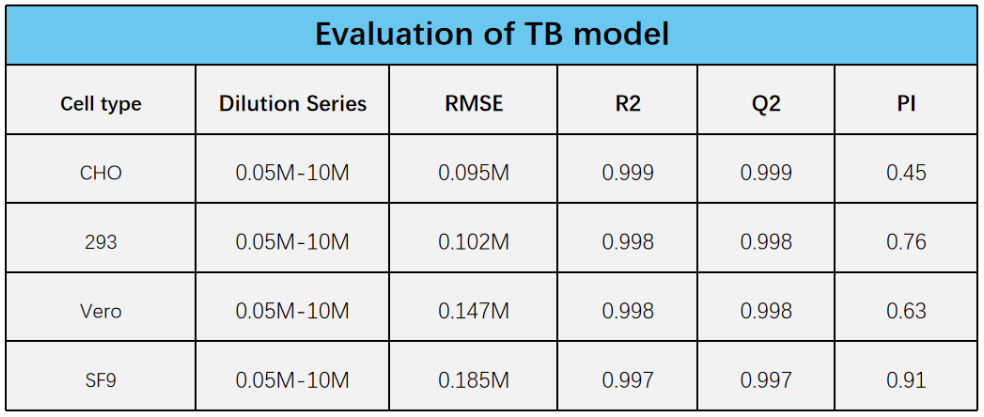

从《AI模型震撼升级:开启智能细胞分析新纪元》及《揭秘超凡智慧CNN》中可以了解到AI模型对不同的细胞类型/生物工艺具有良好的可拓展性与更准确的泛化能力,本期我们一起来探索如何有效训练及准确评估模型的泛化能力。

泛化能力--Generalization

模型泛化是指AI模型对新的、未见过的数据的适应能力,直接关系到AI模型在实际应用中的效果,并且是评估深度学习算法和模型的重要指标之一。在模型训练中,我们通常会将已有的数据集划分为训练集和测试集,使用训练集训练模型,然后使用测试集来评估模型的性能。模型在训练集上表现得好,并不一定能在测试集或实际应用中表现得好。因此,需要保证模型具有良好的泛化能力,才能确保其在实际场景中的效果。

为了提高模型的泛化能力,我们通常需要采取一系列措施,例如增加数据集的大小、 特征选择、特征缩放、正则化、交叉验证等。通过这些方法可以减少横型的过拟合,提高对新数据的预测能力。

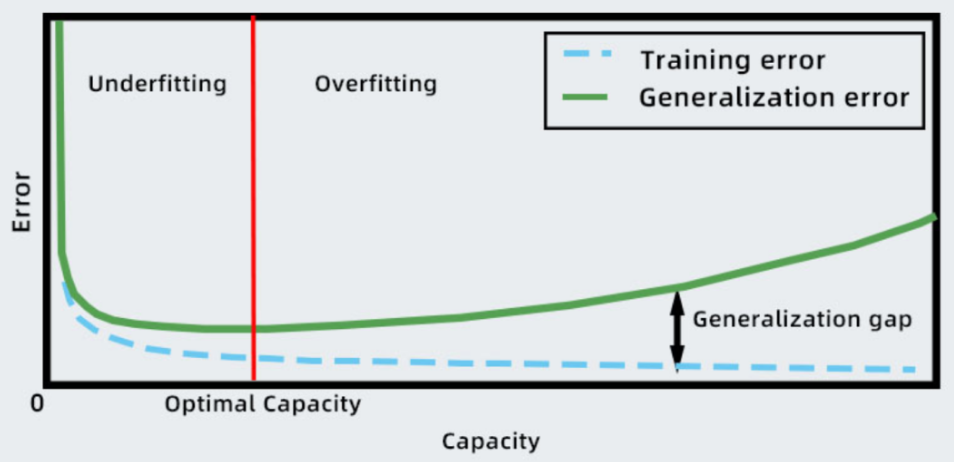

泛化误差(Generalization Error)指的是机器学习模型在新数据上的性能表现与其在训练数据上的表现之间的差异。它是衡量模型泛化能力的重要指标,用于评估模型是否能够正确地推广到未见过的数据上。

创建数据集--Dataset

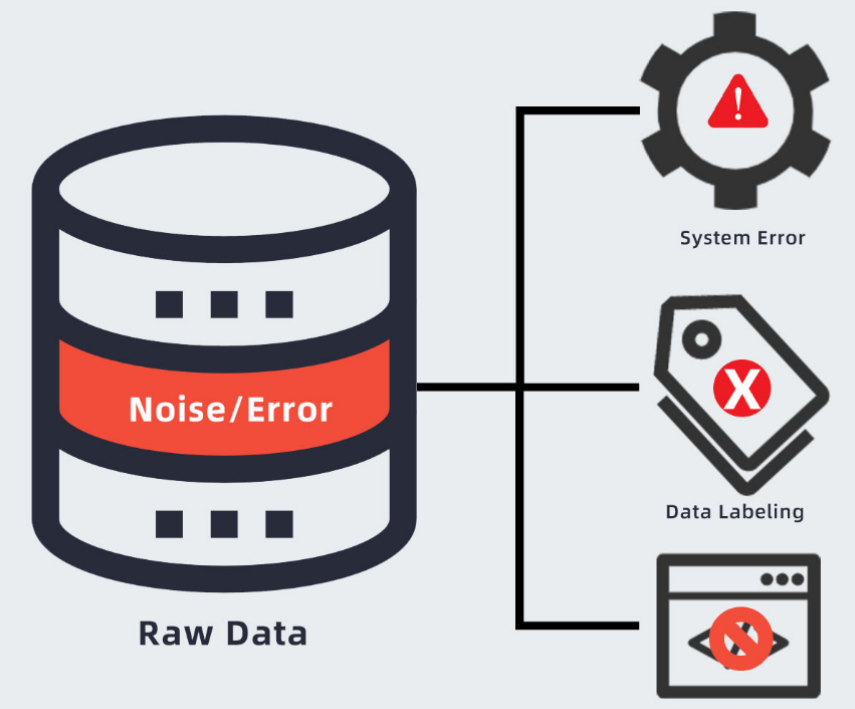

面临最大的挑战是创建数据集,而不是设计模型结构。训练一个AI 模型需要大量一致性的、清晰标注的数据。这样的数据集大多不存在。往往被忽视的是数据是有噪声的,原始数据本身包含许多错误和噪声。数据通过许多来源收集,它们之间也有系统上的差异(系统误差);许多数据的标注标签可能是不准确的;数据不是机器可读的形式。

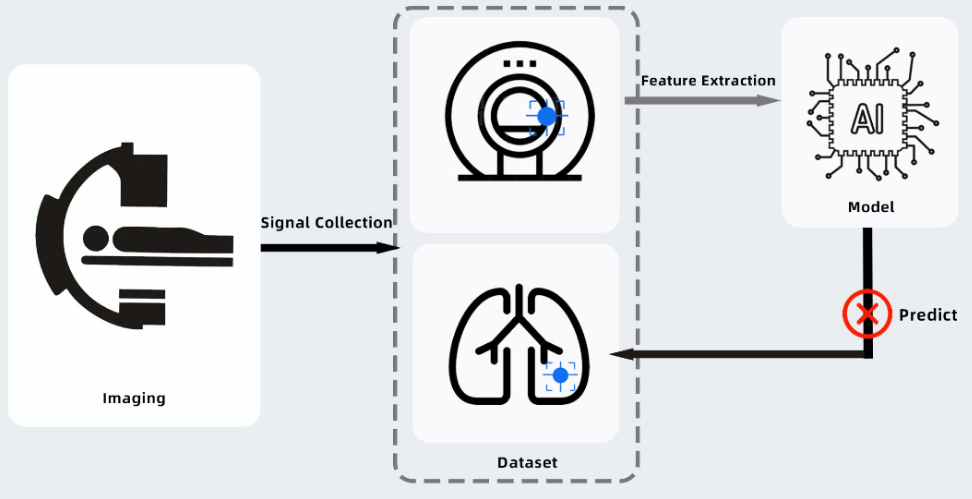

例如在模型辅助医学CT影像诊断过程中,经常出现模型从图像中提取了非医学因素,如模型会隐秘地学习识别特定医学扫描的扫描中心,即模型训练学习的是扫描中心的CT采样设备的特征规律而非影像的医学诊断特征。

数据清洗(Data Cleaning)在生命科学中使用的数据集是非常具有挑战性的,大部分数据集都包含了系统性误差。如果AI模型不适用于生命科学任务,那么根本原因很可能不是模型算法问题,而是模型训练的数据源中的系统误差。

在高内涵分析筛选中,不准确的图像标注会导致模型出现过拟合现象,有时模型学习到是标注人员的特定习惯而非图像中的生物学规律;在PAT光谱建模过程中,未经清洗的光谱数据导致模型学习到是数据集中的噪声特征而非数据模式,最终无法保证新一轮工艺生产的泛化效果。

模型评价与误差分析

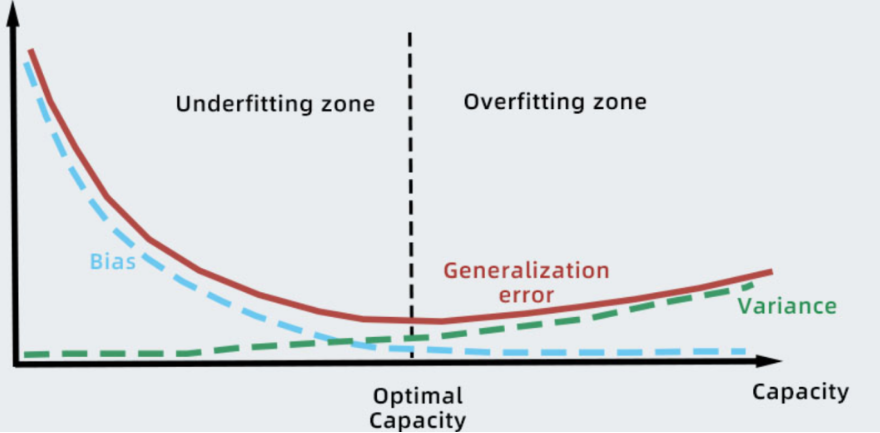

AI模型预测时的误差分析分为两类:偏差 (Bias)和方差(Variance)。偏差和方差反映估计量的两个不同误差来源。偏差反映偏离真实函数或参数的误差期望,而方差反映数据在任意特定采样可能导致的预测期望的偏差。

过拟合与欠拟合

过拟合 (Overfitting):模型在训练数据上表现很好,但在未见过的测试数据上表现较差的情况。过拟合发生的原因是模型过于复杂,能够记住训练数据的细节和噪声,而不是学习数据的通用模式。对样本集拟合得很好,但是假设函数过于畸形,预测时忽左忽右,方差大。

欠拟合(Underfitting):模型太过简单,无法捕获数据中的关键特征和模式。模型在训练数据和测试数据上的性能都较差。假设函数太不自由,过于简单,连样本集都拟合不好,预测时容易偏向一侧,偏差大。

偏差和方差的关系与模型学习容量、欠拟合与过拟合紧密相联。

过拟合出现原因

建模样本选取有误,如样本数量太少,选样方法错误,样本标签错误等,导致选取的样本数据不足以代表预定的分类规则;

噪声干扰过大,使得模型将部分噪音认为是特征从而扰乱了预设的分类规则;

假设的模型无法合理存在,或者说是假设成立的条件实际并不成立;

参数太多,模型复杂度过高;

对于神经网络模型:a)对样本数据可能存在分类决策面不唯一,随着学习的进行,算法使权值可能收敛过于复杂的决策面;b)权值学习迭代次数足够多(Overtraining),拟合了训练数据中的。

模型训练与选择

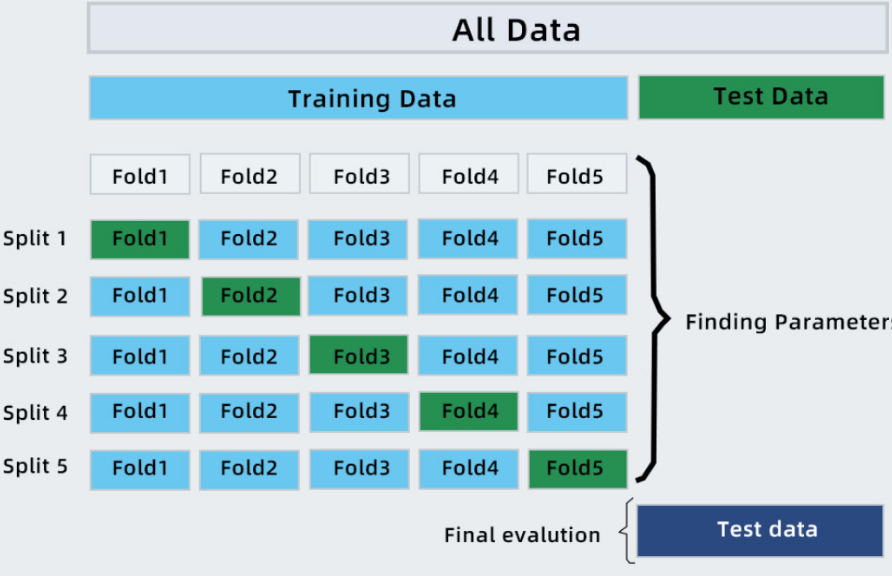

交叉验证是一种常用的评估模型性能和估计泛化误差的方法之一。常见的交叉验证方法是K折交叉验证(K-fold cross-validation)。它将原始数据集分为K个子集(一般取K=5或K=10),每次将其中一个子集作为测试集,剩下的K-1个子集作为训练集,然后进行模型训练和性能评估。这个过程会重复K次,每次选择不同的子集作为测试集,最终得到K个性能评估结果。

您可关注浚真生命科学官网www.bioaces.com,近期,我们将在网站开通数据清洁与模型评估小插件下载入口,欢迎下载体验。